Dowerjai, no prowerjai – Vertrauen ist gut, Kontrolle ist besser?

Gemäß Art. 13 Abs. 2 lit. f) und Art. 14 Abs. 2 lit. g) hat der datenverarbeitende Verantwortliche im Zuge des Transparenzgebots den Betroffenen über das Bestehen einer automatisierten Entscheidungsfindung zu informieren und ihm aussagekräftige Informationen über die involvierte Logik sowie die Tragweite und die angestrebten Auswirkungen einer derartigen Verarbeitung für die betroffene Person zu liefern.

Diese Anforderungen hat der Verantwortliche bereits vor einem Profiling vorzunehmen.

Zusätzlich hierzu ist dem Art. 22 Abs. 3 DSGVO zu entnehmen, dass derartige Profiling-Praktiken mit angemessenen Garantien verbunden sein müssen. Hierunter fällt unteranderem 1. der Anspruch des Betroffenen auf ein menschliches Eingreifen seitens des Verantwortlichen, sofern er ein berechtigtes Interesse hieran hat, 2. die Darlegung des eigenen Standpunkts, auf Erläuterung der nach einer entsprechenden Bewertung getroffenen Entscheidung 3. sowie des Rechts auf Anfechtung der Entscheidung (nicht zu verwechseln mit dem Widerspruch nach Art. 21 DSGVO). Folgt man dieser strengen Lesart des Abs. 3, hätte sich der Data Scientist demnach einer vollumfänglichen Kontrolle zu unterwerfen.

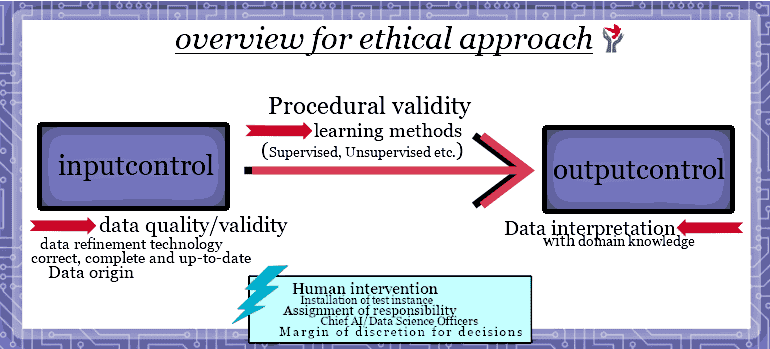

Um das Pferd nicht von hinten aufzuzäumen und den Datenschutz zu operationalisieren, müsste sich der Data Scientist vorab damit befassen, welche Daten verwendet werden, welche Algorithmen und Annahmen er/sie verwendet und wie sich der Algorithmus und die Lernmodelle auf die Betroffenen auswirken.

Art. 22 DSGVO, Alles nur heiße Luft?!

Beachte: Alle genannten Anforderungen gelten nach herrschender Auffassung nur für vollständig automatisierte Entscheidungen, einschließlich Profilingpraktiken.

Art. 22 DSGVO ist also weder Gespenst noch Hemmschuh für Tätigkeiten und Anwendungen, die ein menschliches Eingreifen ermöglichen und nutzen. Kurzum: Also nur unter diesen Umständen, müsste der Verantwortliche den Betroffenen benachrichtigen, ihm die „involvierte Logik“ hierin erklären, mögliche Konsequenzen auflisten, ihn am Prozess beteiligen lassen und dann die Möglichkeit zum Ausstieg bieten.

Mit „involvierte Logik“ sind wohl die Abfolgen, der Aufbau, die gesamte Konstruktion der Entscheidung gemeint. Insoweit hat der Verantwortliche hier seine Entscheidungskriterien darzulegen. Der Betroffene müsste anhand dieser Kriterien erkennen können, wie diese oder jene Entscheidung zustande gekommen ist. Ziel dieser Normen ist also auch die Überprüfbarkeit der Entscheidungen.

Um das Pferd nicht von hinten aufzuzäumen und den Datenschutz zu operationalisieren, müsste sich der Data Scientist vorab damit befassen, welche Daten verwendet werden, welche Algorithmen und Annahmen er/sie verwendet und wie sich der Algorithmus und die Lernmodelle auf die Betroffenen auswirken.

Außerdem können sich die datenverarbeitenden Verantwortlichen im Zuge der Informationsflicht nicht mehr hinter einer fachspezifischen Terminologie verstecken. Denn Art. 12 Abs. 1 DSGVO verlangt eine verständliche, klare und eindeutige Sprache. Abstrakte Erläuterungen des Profiling werden wohl den Ansprüchen des Art. 12 DSGVO nicht genügen. Aber wie tief die Darstellungen im technischen Bereich letztlich sein müssen, will uns die DSGVO nicht verraten. Letztlich wird es dem Verantwortlichen überlassen, in welcher Art und Weise er eine Erklärung der Vorgänge und Mechanismen vornimmt.

Dies stellt für einige Data Scientist generell eine Herausforderung dar. Denn der gemeine Data Scientist wäre nach diesen Vorschriften dazu angehalten, seine Systeme zum einen erklärbar, überprüfbar und intervenierbar, also zugänglicher zu machen und zum anderen sich damit abzufinden, dass viele Betroffene anhand dieser Informationen den Fortgang der Analyse regelmäßig unterbrechen könnten. Insbesondere im Unsupervised-Verfahren wird diese Vorgehensweise eine besondere Herausforderung darstellen.

Hinsichtlich der Kunden von Data Science-Dienstleistungen und -Produkten ist dieser Punkt sicherlich auch bedeutsam. Denn am Ende hat auch der Anwender dieser Produkte die Datenschutzgesetze zu beachten und seine Anwendungen erklärbar darzustellen.

Wertvolles Know-How

Insbesondere bei bereichsspezifischen Data-Science-Projekten können die passenden Methoden, Algorithmen, Verfahren, Geschäftsstrategien, Branchenwissen und die entsprechenden mathematischen Lernstilanwendungen, also die gesamte Herangehensweise, als wirtschaftlich wertvolles Know-How einzustufen sein.

Data Science als Geschäftsgeheimnis?

Inwieweit das neue Geschäftsgeheimnisgesetz dem Informationsrecht des Betroffenen einen Strich durch die Rechnung machen könnte, ist auch noch ungeklärt. Das hängt letztlich davon ab, wie die Anforderungen der DSGVO an die Tragweite der Erklärbarkeit, Überprüfbarkeit und der Interventionsrechte, zu verstehen sind. Die Offenlegung von Abläufen und Strukturen, und damit der Entscheidungskriterien eines Data Scientists könnten, insbesondere bei bereichsspezifischen Data Science-Projekten, zur Offenbarung von relevanten Informationen führen. Außerdem wird es auch Fälle geben, in denen erst eine Offenlegung von Algorithmen oder relevanten Datenanalyseanwendungen für ein Verständnis des Betroffenen sorgen. Aber auch die Möglichkeit der Betroffenen die Entscheidungen zu überprüfen, stellen für die Geschäftsgeheimnisse des Verantwortlichen eine potenzielle Bedrohung dar.

Insoweit könnte es fraglich sein, ob sich ein Verantwortlicher bei derartigen Offenbarungen seiner Algorithmen und mathematischen Formeln auf sein Geheimhaltungsbedürfnis stützen könnte.

Insbesondere bei bereichsspezifischen Data-Science-Projekten können die passenden Methoden, Algorithmen, Verfahren, Geschäftsstrategien, Branchenwissen und die entsprechenden mathematischen Lernstilanwendungen, also die gesamte Herangehensweise, als wirtschaftlich wertvolles Know-How einzustufen sein.

Zum besseren Verständnis: Das Know-How eines Data Science-Projektes besteht nicht nur aus seinen mathematischen und informatischen Anwendungen, sondern auch im Wesentlichen aus einem bereichsspezifischen Wissen über die jeweilige Branche (Domänenwissen). Sämtliche mathematische Analysemethoden würden Fehl laufen, wenn das nötige Domänenwissen fehlt. Dieses Expertenwissen ist demnach auch ein Teil des Geschäftsgeheimnisses. Denn das neue Geschäftsgeheimnisgesetz legt beim Begriff des Geschäftsgeheimnisses nun ein extensiveres Verständnis an den Tag.

Hinzu kommt, dass das neue Geschäftsgeheimnisgesetz „angemessene Geheimhaltungsmaßnahmen“ erfordert (siehe § 2 Nr. 1 b) GeschGehG). Wer diese technischen, organisatorischen und rechtlichen Maßnahmen nicht ergreift (keine Alibi-Maßnahmen), kann sich auch nicht auf das Geschäftsgeheimnisgesetz berufen, ergo wer jedem Betroffenen sein Innerstes offenbaren müsste, könnte Gefahr laufen sein Know-How zu verlieren. Insofern wäre eine extensive Informationsgewährung und Beteiligung des Betroffenen enorm geschäftsschädigend.

Weiterhin erfordert ein Geschäftsgeheimnis ein „berechtigtes Interesse an der Geheimhaltung“ als subjektives Element (siehe § 2 Nr. 1 c) GeschGehG). Das sogenannte Kriterium des berechtigten Interesses ist der europäischen Richtlinie (EU) 2016/943 zum Schutz von Geschäftsgeheimnissen, fremd und insofern eine deutsche Eigenart. Diese deutsche Eigenart wirft natürlich die Frage auf, ob nun auch rechtswidrige Praktiken hinsichtlich des Datenschutzes, ein berechtigtes Interesse, also ein Geheimhaltungsbedürfnis, hervorrufen. Die Kollision zwischen den Informationsansprüchen des Betroffenen mit dem Recht des Verantwortlichen auf den Schutz seiner Geschäftsgeheimnisse, geht damit in die nächste Runde und bietet viel Abwägungspotenzial. Zumindest dem Schutzzweck des Geschäftsgeheimnisgesetzes laufen umfassende Informationsrechte zuwider.

Diesem ganzen Komplex an berechtigten Sorgen über die Geschäftsgeheimnisse, steht der Betroffene mit seinen Informationsrechten gegenüber, die ihm wenigstens die Möglichkeit geben müssten, sich gegen bestimmte Entscheidungen zu Wehr zu setzen, um nicht am Ende wie ein Ochs vorm Scheunentor zu stehen.

Ein tiefer Blick in deine Codes?

Gegen einen ausufernden und allzu tiefen Einblick in die Codes, Datenbestände und Lernmodelle des Data Scientists spricht bereits der Wortlaut des Erwägungsgrundes 71 DSGVO. Dieser spricht von der „Erläuterung der nach einer entsprechenden Bewertung getroffenen Entscheidung“. Erläutern bedeutet laut dem Duden, einen komplizierten Sachverhalt näher zu erklären, durch Beispiele o. Ä. zu verdeutlichen. Daher ist semantisch betrachtet bereits der Begriff „erläutern“ eine Ausdrucksform für eine eher rudimentäre Beschreibung. Hätte der Verordnungsgeber eine extensive Offenlegung und Begründung gewollt, dann hätte er sie auch deutlicher festgelegt. Das zeigt bereits als Vergleich die drastischere Wortwahl der Marktmissbrauchsverordnung (Art. 19 MAR als Beispiel). Überhaupt, ist der Vergleich von Datenschutzrecht und Bankenregulierungsrecht immer gut dazu geeignet, um festzustellen wie durchschlagend und deutlich der Wortlaut in den diversen Bankenregularien sind und wie seicht sie in den Datenschutzbestimmungen formuliert wurden.

Aber auch der Erwägungsgrund 63 der DSGVO deutet an, dass „Geschäftsgeheimnisse oder Rechte des geistigen Eigentums und insbesondere das Urheberrecht an Software“, nicht beeinträchtigt werden sollten. Allerdings schickt der ErwG 63 direkt hinterher, dass dies nicht dazu führen darf, dass der betroffenen Person jegliche Auskunft verweigert wird. Diesem ganzen Komplex an berechtigten Sorgen über die Geschäftsgeheimnisse, steht der Betroffene mit seinen Informationsrechten gegenüber, die ihm wenigstens die Möglichkeit geben müssten, sich gegen bestimmte Entscheidungen zu Wehr zu setzen, um nicht am Ende wie ein Ochs vorm Scheunentor zu stehen.

Quo Vadis?

Jeder redet über Big Data und KI.Wir wollten diesen Buzzwords mit den üblichen Data Science-Praktiken ein Gesicht im juristischen Kontext verleihen und mit einigen Mythen bezüglich der Datenschutzgrundverordnung aufräumen. Einige Rechtsunsicherheiten haben sich bewahrheitet, aber längst nicht alle. Das mag damit zusammenhängen, dass die Datenschutzgrundverordnung nicht speziell auf Data Science und KI-Anwendungen zugeschnitten wurde. Neue Regulierungen werden daher zu erwarten sein. Die Verpflichtungen der Art. 13, 14, 22 DSGVO geben einen Vorgeschmack auf künftige Regulierungsmaßnahmen. Demgemäß könnte man damit rechnen, dass sich die Informations- und Interventionspflichten vom Standpunkt des zukünftigen Rechts aus, auch auf Hybride-Entscheidungssysteme erstrecken könnten.

Am Ende des Tages ist es wichtig anzuerkennen, dass Big Data und KI Risikotechnologien sind. Risikotechnologien haben positive und negative Aspekte. Die Grundfreiheiten und Grundrechte natürlicher Personen (Art. 1 Abs. 2 DSGVO) werden aber sicherlich nicht von einer effektiveren Allokation von Ressourcen bedroht. Es wäre daher hilfreich, wenn man als Datenschützer nicht immer alle Anwendungen in Bausch und Bogen verurteilt. Negative Aspekte und Schubstangeneffekte wird es reichlich geben und diese sind sicherlich aufmerksam zu beobachten.

Data Science meets the law bedeutet

,dass ein Data Scientist die Auswirkungen dieser rechtlichen Anforderungen verstehen und reflektieren muss. Derartige Projekte müssen stets die Einhaltung der geltenden Gesetze dokumentieren. Denn in vielen Fällen tragen sie die Beweislast. Ungeachtet der Datenschutzgesetze und im eigenen Interesse, bedarf es einheitlicher Richtlinien, wie letztlich die Daten verarbeitet werden, um am Ende eine vertrauenswürdige Umgebung zu schaffen. Data Scientists sollten sich mit den Auswirkungen und den nachfolgenden Anwendungen vertraut machen und diese in ihre Entscheidungen mit einbeziehen. Dazu wären Sie im Übrigen gem. Art. 35 DSGVO in besonders risikoreichen Szenarien im Rahmen einer Risikoanalyse verpflichtet. Vom Standpunkt des zukünftigen Rechts aus, werden diese Risikoanalysen sicherlich auch mehr Aufmerksamkeit erhalten.

Um die Menschenwürde als objektiv-rechtliches Element zu begreifen und effektive Risikoabschätzungen vorzunehmen, berücksichtigen Sie, als Data Scientist, die Auswirkungen nicht nur auf Einzelpersonen, sondern auch auf ein Kollektiv. Warten Sie nicht auf die nächsten Regulierungsmaßnahmen. Setzen Sie eigene Grenzen für bestimmte Nutzungen, um den Prozess der menschlichen Entscheidungsfindung zu bewahren.

Wir sind uns sicher, dass der Data Scientist aus anonymen Aggregaten keine vorschnellen Schlussfolgerungen treffen wird. Wir sind uns auch sicher, dass der Data Scientist kein Interesse daran hat, freie Subjekte am Ende zu Objekten zu machen. Die Mathematikerin nickt stolz!

Am Ende bleibt uns nur eines zu sagen: Sehen Sie auch als Data Scientist, im Kleinen das Große und im Konkreten das Abstrakte.

Ein Jurist mit einem Faible für die Verzahnung von IT und Recht.

Und eine Mathematikerin die auch mit Zahlen umgehen kann.