Ein Gespenst geht immer noch um in der IT-Welt – das Gespenst der Datenschutz-Grundverordnung.

Vielerorts hört man mal wieder, dass viele Unternehmen, in Furcht vor dem Damoklesschwert des DSGVO-Bußgeldes, auf die vielversprechenden Big Data und KI-Praktiken verzichten. Was steckt eigentlich dahinter?

Alle reden in diesem Kontext gerne über Big Data, KI und deep learning. Aber wieso redet keiner über Data Science? Was bedeutet eigentlich Big Data und was ist nun dieses Data Science? Welche Anwendungen, Lernstile und Modelle werden üblicherweise verwendet? Muss jede Anwendung einen Kotau vor der ach so übermächtigen DSGVO machen? Ist die DSGVO wirklich der Hemmschuh, für den ihn viele hier halten?

Fragen über Fragen. Statt sich dem Fatalismus der DSGVO zu ergeben, wollen wir in unserer neuen Artikelreihe „Data Science meets law“ den Data Science-Kosmos näher begutachten, in seine konkreten Anwendungen aufdröseln und ordentlich durchdeklinieren, um gemeinsam am Ende mehr zu sehen, statt nur zu schauen.

Leitfaden zur fünfteiligen Artikelreihe

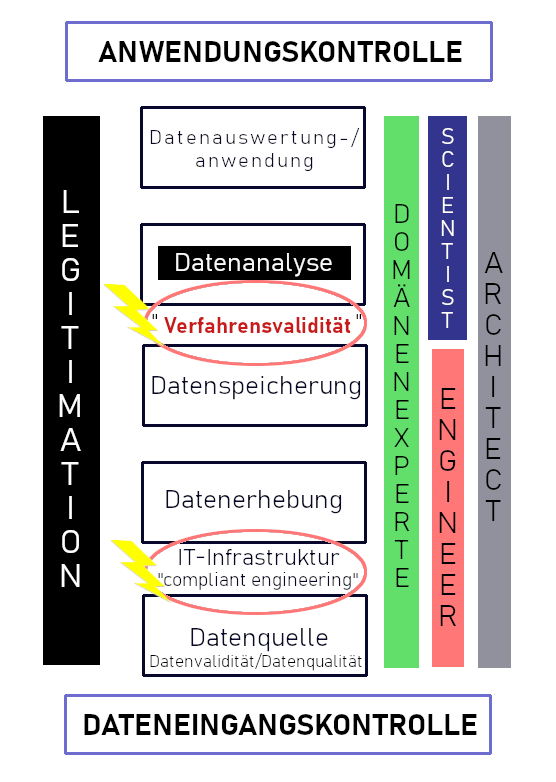

Da die DSGVO den Big Data und Data Science-Kosmos begrifflich ausspart, bedarf es im ersten Teil einer Begriffserläuterung. Um die einzelnen Datenverarbeitungsschritte für eine rechtliche Einordnung zugänglich zu machen, ist im Weiteren eine Kategorisierung der einzelnen Berufsgruppen und Anwendungen notwendig. Dabei springen wir nicht direkt auf die großen Buzzwords wie KI, machine learning und deep learning, sondern konzentrieren uns zunächst auf die Grundlagen der Anwendung. Im zweiten Teil unserer Serie bringt uns unsere Gastautorin, „Die Mathematikerin“, die Methodik und die Lernmodelle nahe. Im letzten Teil stellen wir uns dann den rechtlichen Herausforderungen. Dabei betrachten wir die geltende Rechtslage und unsere Erwartungen für künftige Regulierungen.

Data Science

Big Data bezeichnet eine Sammlung von Daten, die nicht mehr mit dem traditionellen Datenbanksystem zu verarbeiten sind. Um nun Erkenntnisse und Informationen aus den unstrukturierten Daten zu extrahieren, bedarf es spezialisierte Datenmodellierungstechniken. Dieser wissenschaftliche (im Besonderen mathematisch-statistische) Extraktionsprozess wird neudeutsch als Data Science bezeichnet. Genau das unterscheidet den Data Scientist auch vom allbekannten Data Analyst. Data Science ist in gewisser Weise der Bereich, der alles umfasst, was mit Datenbereinigung, Data Mining, Datenaufbereitung, Datenanalyse und Datenvisualisierung zu tun hat.

Wer ist Wer?

Auch in einer arbeitsteiligen Gesellschaft dürfen die folgenden Bezeichnungen nicht in ihrer Partikularität begriffen werden. Sowohl ein Data Engineer oder ein Data Architect als auch ein Data Scientist haben zahlreiche Überschneidungspunkte in ihrer Arbeit. Für viele Unternehmen mag daher eine Aufspaltung dieser Art sehr befremdlich vorkommen. Oft übernimmt die gesamte Arbeit des Data Engineers und des Data Scientists, dann ein Generalist. Hier liegt deshalb auch die erste Ungeschicklichkeit vieler Unternehmen. So wissen viele Unternehmen nicht, nach was sie genau tatsächlich suchen oder was sie benötigen. Demgemäß liest man in vielen Stellenausschreibungen, „wir suchen einen Data Scientist (w/m/y)“.

Im Vorstellungsgespräch stellt sich dann schnell heraus, dass der gewünschte Data Scientist nicht nur die Daten mit den erlernten mathematischen und statistischen Fähigkeiten analysieren soll, sondern zunächst einen funktionierenden Datenbestand entwickeln und verwalten soll. Was das Unternehmen sucht, ist also nicht ein Data Scientist, sondern ein Data Engineer. Also einen waschechten Software-Ingenieur, der im besten Fall den Grundstein für die spätere Arbeit des Data Scientist, legt.

MERKE : Data Science-Projekte sind interdisziplinär.

Um den Vorgang eines Data Science-Projekts im Gesamten zu begreifen, könnte man daher die Berufsgruppen im Folgenden so abgrenzen:

Der Data Engineer/Data Architect

Der Data Architect bildet den Startpunkt und setzt die Rahmenbedingungen für eine zentralisierte Datenplattform. Er hat den Überblick über das gesamte Unternehmen und liefert dem Data Engineer den Blueprint für die technische Umsetzung der Datenplattform. Damit entscheidet er, welche Daten für welche Fragestellung relevant sein könnten und trifft damit eine gewisse Vorabanalyse der Daten. Des Weiteren gewährleistet er die gesamten technischen und organisatorischen Maßnahmen, wie bspw. das Identitäts- und Zugriffsmanagement. Er ist letztlich die Schnittstelle zu allen relevanten Beteiligten.

Der Data Engineer ist der technische Datenaufbereiter. Um aus diversen Datenquellen Informationen zu gewinnen, bedarf es seiner Arbeit. Er entwickelt, wartet, überwacht Daten Ein- und Ausgänge, integriert und verwaltet große Datenmengen aus verschiedenen Datenquellen. Er kümmert sich so gesehen um die Erstellung einer funktionierenden IT-Infrastruktur für die nachfolgende Analyse und letztlich um eine effizientere Datenverfügbarkeit zwischen den verschiedenen Schnittstellen im Unternehmen. Seine Datensatzprozesse erfordern daher ebenfalls einer Vorabanalyse hinsichtlich der Datenqualität.

Damit legen letzten Endes der Data Architect und der Data Engineer auch den Grundstein für die Data Governance und einer datenschutzkonformen Handhabung. Neben einer grundlegenden Vorabkontrolle, welche Daten vor oder nach einer Auswertung einen Personenbezug aufweisen und welche Legitimationen für die Datenverarbeitungen bestehen, haben der Engineer und der Architect eine Datenplattform zu konstruieren, die neben der effektiven Nutzbarkeit auch die Verfügbarkeit zu Beweiszwecken für Betroffene und Aufsichtsbehörden effektiv gewährleistet. Datenplattformen dürften daher nicht undurchdringbar sein, sondern einen Spielraum für Interventionen haben. Somit stellen der Engineer und der Architect im Kontext von Datensicherheit und Datenschutz einen neuralgischen Punkt dar. Wer bereits hier fahrlässig mit der Datensicherheit und dem Datenschutz umgeht, lässt dem Data Scientist und allen nachfolgenden Usern in der Kette, keine wirkliche Chance mehr sich datenschutzkonform bzw. compliant zu verhalten. Der Jurist David Saive prägt hierfür den Begriff „compliant programming“ (Interview mit David Saive). In Zeiten agiler Projekte macht es seiner Ansicht nach nur wenig Sinn, die Juristen erst zum Abschluss eines IT-Projektes mit einzubinden, sondern im Sinne der agilen Methode bereits zu Beginn in alle rechtlich relevanten IT-Prozesse zu integrieren. Insbesondere bei der Strukturierung und dem Aufbau derartiger Datenplattformen werden „compliant programming“, in dem Fall compliant engineering, Herangehensweisen eine überragende Bedeutung erlangen.

Data Mining: Data Mining ist nicht gleich Data Science. Beim Data Mining geht es darum, Trends in einem Datensatz zu finden. Im Vergleich zur klassischen Statistik ist das Data Mining hypothesenfrei. Hypothesenfrei bedeutet in diesem Kontext, dass die Trends noch gar nicht bekannt sind. Data Mining ist so gesehen eine elementare Technik für den Data Scientist, mit der strukturierte Daten nutzbar gemacht werden.

Die Königsdisziplin, Data Science

Data Science ist ein eigenes Forschungsgebiet, welches alle Bereiche von Data Mining bis zu weiteren statistischen und mathematischen Methoden, mit umfasst. Data Scientists nutzen dabei im Wesentlichen zwei Modelle/Verfahren, um wirtschaftlich verwertbare Informationen zu generieren. Das sogenannte Supervised-Model und das sog. Unsupervised-Model. Beim Supervised-Model (Überwachtes Verfahren) gibt es bereits aufbereitete und validierte Daten, die als Lerndatensatz dienen, um zuvor getroffene Hypothesen zu falsifizieren oder verifizieren. Hieraus werden Vorhersagen statistisch ermittelt. Anhand dieser Methode können bspw. Banken mit ihren Erfahrungsdaten feststellen, ob der Kreditnehmer kreditwürdig ist oder eben nicht. Wohingegen im Unsupervised-Verfahren (Unüberwachtes Verfahren) weder ein Lerndatensatz noch eine zu überprüfende Hypothese existiert. In diesem Verfahren steht der Data Scientist vor einer großen und unüberschaubaren Datenmenge. Der Fokus besteht daher in der Erforschung nach unbekannten Instanzen. In diesem Model werden Datensätze durchforstet, ohne zuvor ein Ziel festgesetzt zu haben.

Hieraus erhofft sich der Data Scientist, große und unüberschaubare Datenmengen zu kategorisieren und relevante, aber auch überraschende Zusammenhänge aufzudecken. Über die übliche Praxis eines Data Analysten hinaus, nutzen Data Scientists unteranderem Analyseprogramme für das maschinelle Lernen und künftig auch KI-Anwendungen, wie das sog. „deep learning“. Tätigkeiten dieserart setzen sowohl ein statistisches/mathematisches als auch ein informatisches Verständnis voraus. Die gewonnenen Informationen trägt der Data Scientist anschließend, möglichst verständlich und visualisiert an den Auftraggeber, zumeist die Geschäftsführung, Kampagnenmanager oder den Projektleiter weiter.

Domänenexpertise wins!

Über das mathematische und informatische Wissen hinaus, ist auch ein Domänenwissen erforderlich. Erst diese Bereichsexpertise kann den Data Scientist entscheidend nach vorne bringen. Denn von den Optimierungsmöglichkeiten und -bedürfnissen von Verschleißteilen bei technischen Anlagen versteht ein Maschinenbauer im Zweifel mehr als der gemeine Data Scientist. Folglich kann auch nur ein Jurist die internen Abläufe und rechtlichen Schlussfolgerungen einschätzen (Sorry, Mathematikerin). Wer das beste aus den Daten holen möchte, muss künftig interdisziplinär arbeiten. Und wenn wir von internen Abläufen sprechen, dann meinen wir nicht nur das Beschaffungswesen, sondern etwa auch wie viele Anwälte an einem umfangreichen Fall effektiv arbeiten könnten.

Bye, Bye Wasserfall!

Wer aufmerksam war, wird schnell merken, dass die Daten nun nicht mehr wie bei der klassischen Wasserfall-Modell, von der einen Abteilung stringent zu einer anderen Abteilung gelangen, sondern von diversen und heterogenen Beteiligten beeinflusst werden und damit durch viele Hände gehen. Die gesamte Datenverarbeitungskette ist, wie der Informatiker gerne sagt, agil. Um die Daten auch effizient zu nutzen und die Einbindung aller für den Output relevanten Gruppen, wozu auch die Kunden gehören, zu gewährleisten, ist eine umfassende technische Verknüpfung im Unternehmen notwendig.

Anwendungsfelder

Wirtschaftlich betrachtet gewinnen Data Science Praktiken weltweit an Auftrieb, weil sie letztendlich datenzentrierte Produkte für Unternehmen entwickeln. Und wer hat nicht schon den Spruch gehört: „Daten sind das Öl des 21. Jahrhunderts“. Der Data Engineer holt das Öl, im übertragenen Sinne, aus dem Boden und der Data Scientist verarbeitet das Öl anschließend zu einem Produkt. Die Anwendungsbereiche in der Wirtschaft sind dabei mannigfaltig. Von der Prozessoptimierung in der Warenwirtschaft, Energiewirtschaft etc., also in jeder Supply Chain bis zur Kundengewinnung, durch intelligenteres Prizing und der rechtzeitigen Produktplatzierung, gewinnen derartige Anwendungen immer mehr an Bedeutung. Aber auch im Bereich der IT-Security, dem Risikomanagement, ja selbst internationale Anwaltskanzleien bemühen Data Science Praktiken, um bspw. arbeitsrechtliche Rechtslücken aufzudecken.

Windeln, entmannte Männer und Bier

Um diese Tätigkeit mal plastisch darzustellen, stellen Sie sich hierzu einen frustrierten und „schwer angestrengten“ Vater zur Mitternachtszeit an einer Tankstelle vor. Dieser „schwerermüdete“ und frustrierte Vater sucht nach Babywindeln für sein Neugeborenes. Und sieh einer an: links neben den Babywindeln steht eine Packung Beef Jerky und rechts daneben, wer hätte es gedacht, Bier. Griffbereit sind natürlich auch diverse Kaffee- und Cappuccino-Drinks, mit der Aufschrift „Express“. Ein Schelm, wer Böses dabei denkt. Die unbekannte Instanz: Schlafwandlerische und „entmannte“ Väter, die gegen Mitternacht nach Windeln in einer Tankstelle suchen, mögen Bier und gedörrtes Fleisch. Die Korrelation zwischen Bier und Windeln brachte dem Supermarkt-Riesen Walmart ca. 25 % mehr Umsatz ein.

Hemmschuh DSGVO?

Maschinendaten werden von der DSGVO grundsätzlich nicht erfasst. Bevor man sich auf die hiesigen Datenschutzregelungen stürzt und für das Unheil der Welt verantwortlich macht, sollte man sich daher im gleichen Atemzug mit der fehlenden Digitalisierung hierzulande beschäftigen. Denn häufig scheitern die Analysetätigkeiten eines Data Scientist bereits an der fehlenden IT-Infrastruktur, also unteranderem an der nicht vorhandenen Datenmenge oder an der Erfassung von validen Daten. Viele KMUs bspw. erfassen ihre technischen Daten immer noch händisch und händisch erfasste Daten erzeugen im weiteren Verlauf einer Data Science Analyse prinzipiell keine korrekten Resultate. Was somit für viele Beobachter gerne als Hemmschuh taxiert wird, stellt sich hinsichtlich der Maschinendaten grundsätzlich als Trugschluss dar.

Ein Jurist mit einem Faible für die Verzahnung von IT und Recht.

Und eine Mathematikerin die auch mit Zahlen umgehen kann.